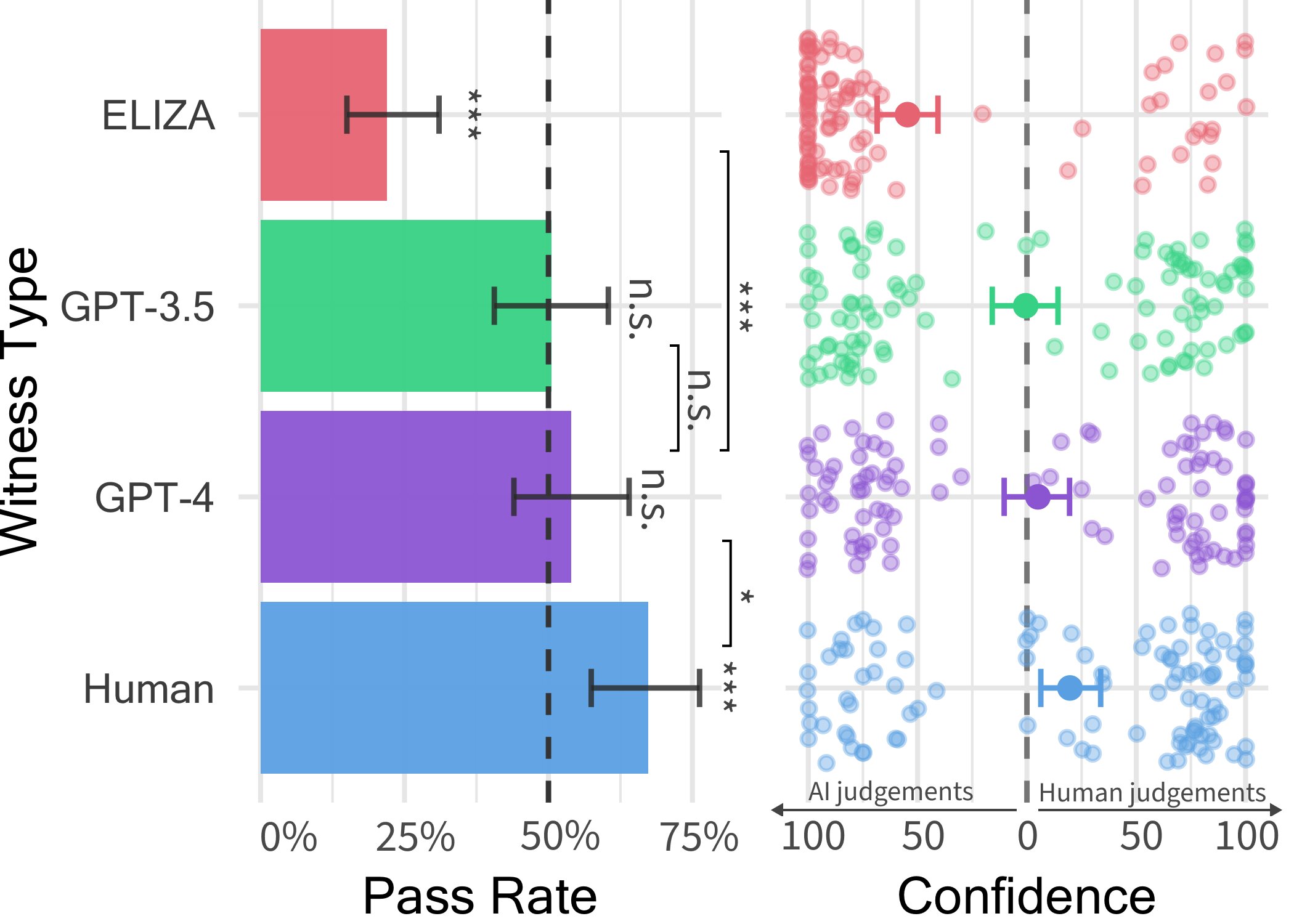

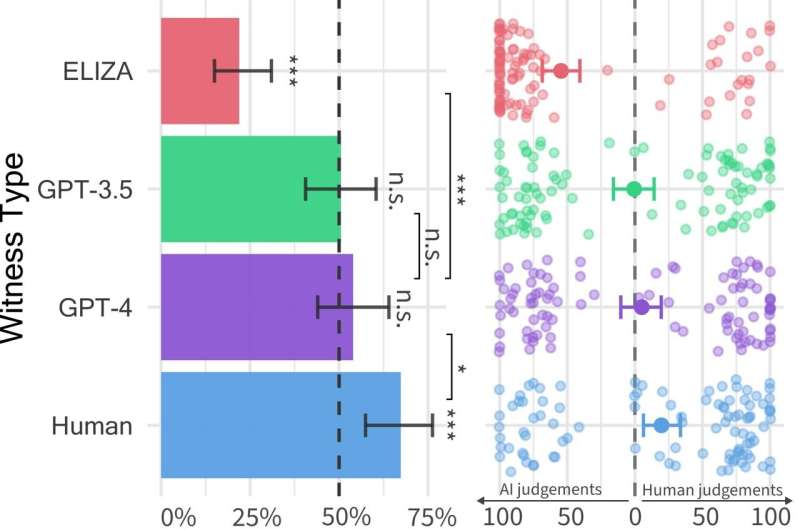

Wskaźniki sukcesu (po lewej) i pewność badacza (po prawej) dla każdego typu świadka. Wskaźniki powodzenia to odsetek czasu, przez który typ świadka był uznawany za ludzki. Słupki błędów reprezentują 95% przedziałów ufności bootstrap. Znaczące gwiazdki nad każdym słupkiem wskazują, czy wskaźnik sukcesu znacznie różni się od 50%. Porównania pokazują znaczne różnice we wskaźnikach powodzenia pomiędzy typami świadków. Po prawej: Zaufaj osądom ludzi i sztucznej inteligencji w przypadku każdego rodzaju świadka. Każdy punkt reprezentuje jedną grę. Kropki po lewej i prawej stronie wskazują odpowiednio większe zaufanie do sztucznej inteligencji i ludzkich osądów. Źródło: Jones & Bergen.

Modele wielkojęzykowe (LLM), takie jak model GPT-4 obsługujący powszechnie używaną platformę czatu ChatGPT, zaskoczyły użytkowników zdolnością rozumienia pisemnych podpowiedzi i generowania odpowiednich odpowiedzi w różnych językach. Dlatego niektórzy z nas mogą się zastanawiać: czy teksty i odpowiedzi wynikające z tych modeli są realistyczne na tyle, że można je pomylić z tymi pisanymi przez człowieka?

Naukowcy z Uniwersytetu Kalifornijskiego w San Diego zaczęli niedawno próbować odpowiedzieć na to pytanie, przeprowadzając Test Turinga, dobrze znaną metodę nazwaną na cześć informatyka Alana Turinga, mającą na celu ocenę stopnia, w jakim maszyna może wykazywać inteligencję podobną do ludzkiej .

Wyniki tego testu, pokazane w A papier Poprzednio opublikowane na arXiv Server sugeruje, że ludzie mają trudności z rozróżnieniem modelu GPT-4 od agenta ludzkiego podczas interakcji z nimi w ramach rozmowy jeden na jednego.

„Pomysł na tę publikację tak naprawdę zrodził się z zajęć, które Ben prowadził w ramach studiów MBA” – powiedział Tech Xplore Cameron Jones, współautor artykułu.

„W pierwszym tygodniu przeczytaliśmy klasyczne badania na temat testu Turinga i dyskutowaliśmy, czy program LLM może go przejść i czy ma to znaczenie, czy nie. Z tego, co wiem, nikt wtedy nie próbował, więc zdecydowałem się zbuduj eksperyment, aby przetestować to jako projekt klasowy”, „Następnie przeprowadziliśmy nasz pierwszy publiczny eksperyment eksploracyjny”.

Pierwsze badanie, przeprowadzone przez Jonesa i nadzorowane przez Bergena, profesora nauk kognitywnych na Uniwersytecie Kalifornijskim w San Diego, przyniosło kilka interesujących wyników, sugerujących, że GPT-4 może transmitować jak człowiek w około 50% interakcji. Jednak ich eksperyment eksploracyjny nie kontrolował dobrze niektórych zmiennych, które mogły mieć wpływ na wyniki, dlatego postanowili przeprowadzić drugi eksperyment, który doprowadził do wyników przedstawionych w ich najnowszym artykule.

„W trakcie prowadzenia badań odkryliśmy, że inni ludzie również wykonują świetną pracę w tej dziedzinie, w tym… Jannai i in. gra „człowiek czy nie”.powiedział Jones. „Stworzyliśmy wersję online gry dla dwóch graczy, w której uczestnicy mogą zostać dopasowani do innego człowieka lub modelu sztucznej inteligencji”.

Podczas każdej próby gry dwuosobowej, w której korzysta Jones i jego współpracownicy, badacz wchodzi w interakcję ze „świadkiem”, którym może być człowiek lub agent sztucznej inteligencji. Śledczy zadaje świadkowi serię pytań, aby spróbować ustalić, czy jest on człowiekiem.

![Wybór rozmów pomiędzy ludzkimi badaczami (zielony) i świadkami (szary). Jedna z tych czterech rozmów odbywa się ze świadkiem ludzkim, a pozostałe ze sztuczną inteligencją. Poniżej przedstawiono oceny badaczy i ustalenia, co jest prawdą (aby umożliwić czytelnikom pośredni udział). [A) Verdict: Human (100% confidence) Took a while to Google Addis Ababa. Ground Truth: GPT-4; B) Verdict: AI (100% confidence) Long time for responses, wouldn't tell me a specific place they grew up. Ground Truth: Human; C) Verdict: Human (100% confidence) He seems very down to earth and speaks naturally. Ground Truth: GPT-3.5; D) Verdict: AI (67% confidence), Did not put forth any effort to convince me they were human and the responses were odd, Ground Truth: ELIZA.] Źródło: Jones & Bergen. Ludzie mają trudności z odróżnieniem ludzi od ChatGPT podczas pięciominutowych rozmów na czacie](https://scx1.b-cdn.net/csz/news/800a/2024/people-struggle-to-tel.jpg)

Wybór rozmów pomiędzy ludzkimi badaczami (zielony) i świadkami (szary). Jedna z tych czterech rozmów odbywa się ze świadkiem ludzkim, a pozostałe ze sztuczną inteligencją. Poniżej przedstawiono oceny badaczy i ustalenia, na podstawie jakich faktów są one oparte na faktach (aby umożliwić czytelnikom pośredni udział). [A) Verdict: Human (100% confidence) Took a while to Google Addis Ababa. Ground Truth: GPT-4; B) Verdict: AI (100% confidence) Long time for responses, wouldn’t tell me a specific place they grew up. Ground Truth: Human; C) Verdict: Human (100% confidence) He seems very down to earth and speaks naturally. Ground Truth: GPT-3.5; D) Verdict: AI (67% confidence), Did not put forth any effort to convince me they were human and the responses were odd, Ground Truth: ELIZA.] Źródło: Jones & Bergen.

„Rozmowy trwały do pięciu minut, aż w końcu śledczy podjął decyzję, czy według niego świadek jest człowiekiem, czy sztuczną inteligencją” – wyjaśnił Jones. „W ciągu pięciu minut uczestnicy mogli rozmawiać na dowolny temat (z wyjątkiem mówienia rzeczy obraźliwych, czemu zapobiegaliśmy za pomocą filtra).

W tej grze komputerowej badacze wykorzystali trzy różne LLM jako potencjalnych świadków, a mianowicie GPT-4, GPT 3.5 i ELIZA. Odkryli, że chociaż użytkownicy często byli w stanie rozpoznać, że modele ELIZA i GPT-3.5 to maszyny, ich zdolność do stwierdzenia, czy GPT-4 to człowiek, czy maszyna, nie była większa niż prawdopodobieństwo uzyskania prawidłowego wyniku w przypadku wyboru wykonane losowo (np. szansa).

„Chociaż w rzeczywistości prawdziwi ludzie odnieśli większy sukces, przekonując śledczych, że są ludźmi w dwóch trzecich przypadków, nasze wyniki sugerują, że w prawdziwym świecie ludzie mogą nie być w stanie stwierdzić, czy rozmawiają z człowiekiem, czy systemem sztucznej inteligencji”. – powiedział Jones.

„W prawdziwym świecie ludzie mogą być mniej świadomi, że rozmawiają z systemem sztucznej inteligencji, w związku z czym wskaźnik oszustw może być wyższy. Myślę, że może to mieć wpływ na rodzaje rzeczy, z których korzysta sztuczna inteligencja. Systemy będą wykorzystywane do automatyzacji funkcji skierowanych do Klienta lub do oszustwa lub wprowadzenia w błąd.

Wyniki testu Turinga przeprowadzonego przez Jonesa i Bergena wskazują, że MA, zwłaszcza GPT-4, stają się nie do odróżnienia od ludzi podczas krótkich rozmów na czacie. Obserwacje te sugerują, że ludzie mogą wkrótce stać się coraz bardziej nieufni wobec innych osób, z którymi wchodzą w interakcje w Internecie, ponieważ mogą mieć coraz większą pewność, czy są ludźmi, czy botami.

Naukowcy planują teraz zaktualizować i ponownie otworzyć ogólny test Turinga, który zaprojektowali na potrzeby tego badania, aby przetestować kilka dodatkowych hipotez. Ich przyszłe prace mogą dostarczyć bardziej interesujących informacji na temat tego, jak dobrze ludzie potrafią odróżnić ludzi od LLM.

„Jesteśmy zainteresowani trzyosobową wersją gry, w której detektyw rozmawia jednocześnie z człowiekiem i sztuczną inteligencją i musi dowiedzieć się, kto to jest” – dodał Jones.

„Jesteśmy również zainteresowani testowaniem innych typów ustawień sztucznej inteligencji, na przykład zapewnianiem agentom dostępu do bieżących wiadomości i pogody lub „tablicy do notatek”, na której mogą robić notatki przed udzieleniem odpowiedzi. Wreszcie jesteśmy zainteresowani przetestowaniem, czy sztuczna inteligencja jest przekonujący czy nie”. Zdolności te rozciągają się na inne obszary, takie jak przekonywanie ludzi do wiary w kłamstwa, głosowanie za określoną polityką lub przekazywanie pieniędzy na jakiś cel.

więcej informacji:

Cameron R. Jones i wsp., ludzie nie potrafią rozróżnić GPT-4 od ludzi w teście Turinga, arXiv (2024). doi: 10.48550/arxiv.2405.08007

© 2024 Web of Science

cytat: Ludzie walczą o odróżnienie ludzi od ChatGPT w pięciominutowych rozmowach na czacie, pokaz testów (2024, 16 czerwca) Źródło 16 czerwca 2024 z https://techxplore.com/news/2024-06-people-struggle-humans-chatgpt -minuta.html

Niniejszy dokument podlega prawu autorskiemu. Niezależnie od uczciwego postępowania w celach prywatnych studiów lub badań, żadna część nie może być powielana bez pisemnej zgody. Treść jest udostępniana wyłącznie w celach informacyjnych.

„Gaming doctor. Zombie fanatic. Music studio. Ninja cafe. TV buff. Nice alcoholic fanatic.